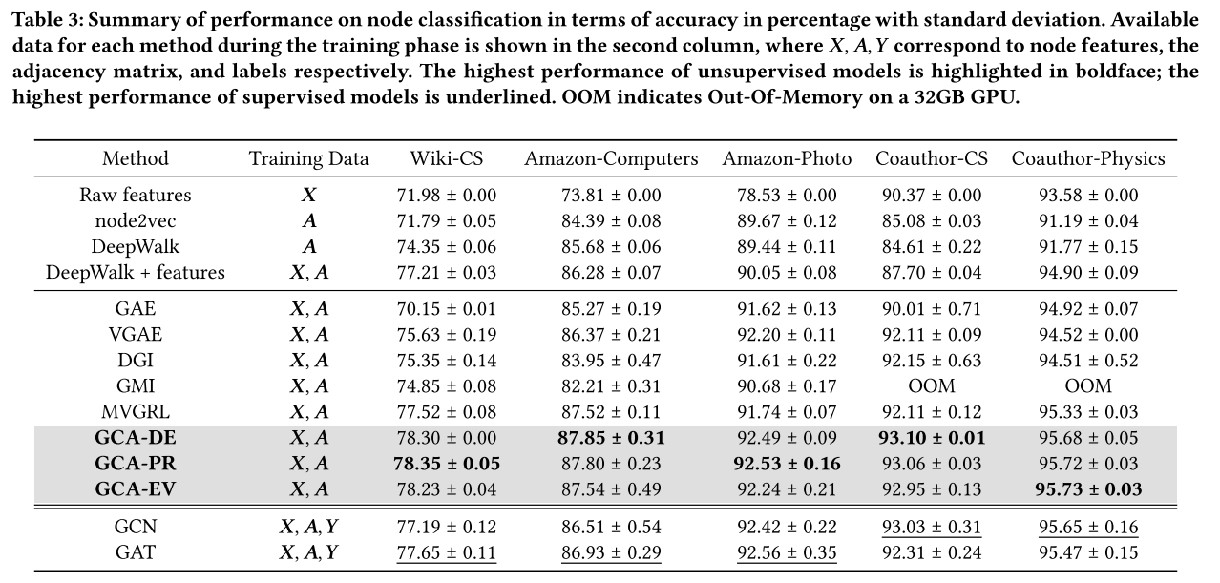

近年来,对比学习(CL)已成为一种成功的无监督图表示学习方法。大多数图对比学习方法首先对输入图进行随机增强,以获得两个图视图,并最大化两个视图中表示的一致性。尽管图对比学习方法得到了繁荣的发展,但数据增强方案的设计却比较少,数据增强方案应保留图的固有结构和属性,只对不太重要的节点和边进行扰动。这样,模型才能在不同版本的图中识别并保持关键部分的表示一致,同时对无关或不重要的部分变化不敏感,学到更加稳健的图表示。

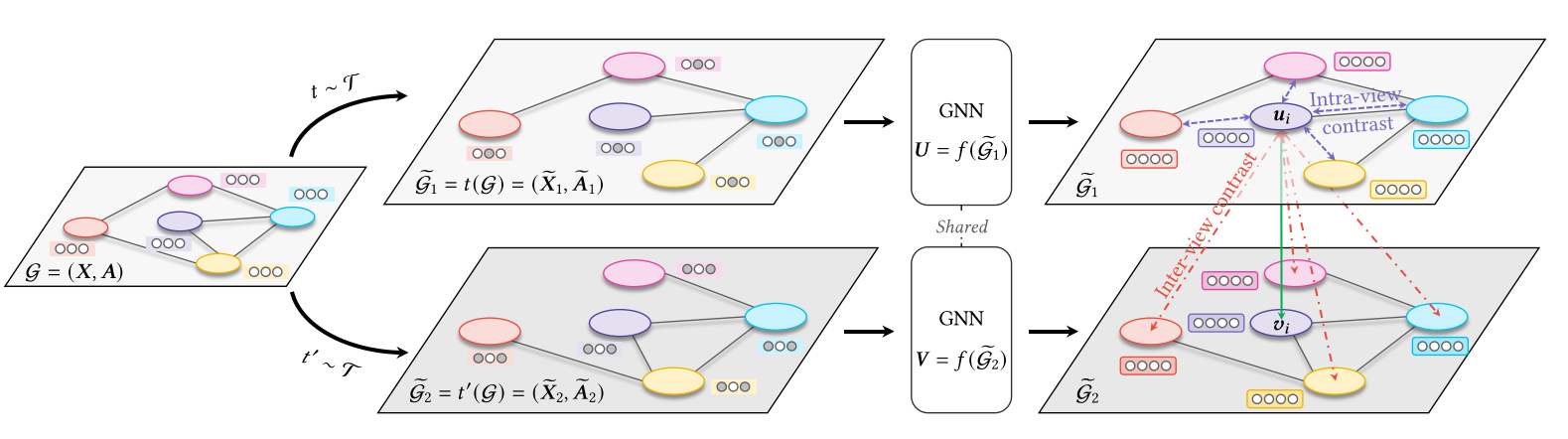

该论文提出一种自适应增强的图对比学习方法(Graph Contrastive learning with Adaptive augmentation, GCA),通过为图中的边和节点特征引入可学习的扰动或删除概率,从而在对比学习中自动识别和保留关键结构,并对不重要信息进行适度扰动。

具体而言,模型先利用可微的增广模块对原始图进行两次自适应增广,再将增广后的两个视图分别输入同一 GNN 编码器,最终通过对比损失来学习对关键信息更敏感、对噪声更鲁棒的表示。

然后,使用公式2(InfoNCE损失)计算对比目标 J ,旨在最大化同一节点在两视图中的嵌入一致性,同时最小化不同节点嵌入的相似性。 使用随机梯度上升法优化对比目标 J ,更新模型参数。